Google Pixel 6/6 Proの翻訳機能はiP...

03

03

Google Pixel 6/6 Proの翻訳機能はiPhoneユーザーから見ても羨ましい

Androidは、基本的にはGoogleがOSを作り、SamsungやHUAWEIなどのスマホメーカーがハードウェアを作るという構造になっている。しかし、Googleがソフトウェア的に強化したい方向性を提案するために、自社で独自に開発販売しているのがGoogle Pixelシリーズだ。

スマホの性能競争は、機械学習専用チップの有無が争点に

そのPixel の6/6 Proで新たに搭載されたのがTensorというGoogle独自のチップ。これには、iPhone独自のチップセットであるAシリーズチップ(最新はiPhone 13シリーズに搭載されるA15 Bionic)のNeural Engineと同じく機械学習に特化した回路が組み込まれている。人工知能! AI! と言ってしまうと話がややこしくなるが、従来の『if~then~eles』というようなロジックを人間が組み立てるルールベースのプログラミングではなく、大量の学習データを読み込ませることでコンピュータ自体が学習して認識、識別できるフィルターを作る処理で、画像認識や文字認識、音声認識に効果を発揮する。簡単にいうと、従来のプログラミングでネコを判別しようとすると、胴体と頭部があって、四本足があって、目が二つこのぐらいの距離であって、全体にモフモフした毛に覆われていて……と細かい識別条件分けが必要だったが、今は大量のネコの写真を入力することで、ネコの画像的特徴を(人が理解できないカタチではあるが)抽出できる。その処理に特化して高速化できるようにした回路が、iPhoneのNeural Engineだったり、GoogleのTensorだったりするというわけだ。

実用的なGoogle Pixel 6/6 Proの翻訳機能

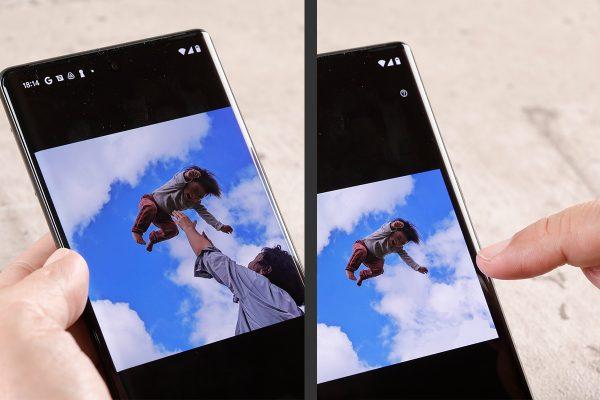

海外メディアのレポートによると、チップセットの性能としてはTensorの機械学習回路の処理能力は、Neural Engineに遠く及ばないらしいが、実装としてはかなり便利に使えるものになっている。このあたり、チップセットの設計としては垂直統合型のビジネスを展開しているアップルが先行したが、学習データに関しては従来からGoogle翻訳や、Googleフォトなどで無料で学習データを大量に入手していたGoogleの方が先行するという構図で、興味深い。たとえは、Google Pixel 6/6 Proでは、メッセージの中で翻訳を使うことができる。精度はかなりのもので、これを使えば、私のような英語が苦手な人でも海外の人と普通にメッセージをやりとりできる。